Терминаторы на подходе.

Терминаторы на подходе.Пентагон легализовал искусственный интеллект с летальным уклоном

Терминаторы на подходе.

Терминаторы на подходе.Искусственный интеллект смертоносной силы

В январе Пентагон утвердил директиву 3000.09 Autonomy in Weapon System, регулирующую правовые коллизии, которые в течение одиннадцати лет ограничивали разработку, испытания и применение систем вооружения с элементами искусственного интеллекта. Если прежде считалось, что не боевому роботу определять, кого убивать, а кого миловать, то с этого момента этические ограничения, получается, как бы сняты - «умное оружие» можно конструировать и применять по прямому назначению. Правда, под усиленным контролем.

Впрочем, вопреки распространённому мнению, американское военное ведомство никогда не руководствовалось жёстким запретом на использование автономного и полуавтономного оружия с летальным уклоном. Но при этом были формальные препятствия, которые не позволяли американским генералам (типа Уэсли Кларка и др.) выходить за пределы обсуждений и теорий - якобы мешала некая «путаница» в федеральном законодательстве. На самом деле, как утверждает директор проекта управления искусственным интеллектом, старший научный сотрудник программы стратегических технологий в Центре стратегических и международных исследований Грег Аллен, никакого запрета не было.

Боевой робот армии США запускает ракету Javelin.

Боевой робот армии США запускает ракету Javelin.«Такого требования нет ни в политике 2012 года DODD 3000.09, ни в какой-либо другой политике Министерства обороны», - объяснил Аллен. По его словам, первоначальная доктрина 2012 года гласит, что военные могут производить такие системы вооружения, но исключительно после «процесса проверки на высшем уровне». Но вот что примечательно: согласно отчёту исследовательской службы Конгресса, опубликованному в 2019 году, ни один «умный» продукт американского ВПК контроль не проходил. Просто установки были прописаны настолько нечётко, что военные специалисты сами пришли к выводу, будто им строго запрещено создавать, тестировать и применять летальное автономное оружие.

Но теперь всё встало на свои места. Согласно новой редакции доктрины, американскому военному ведомству по части применения искусственного интеллекта можно практически всё. Например, не только изобретать и тестировать, но и применять автономные и полуавтономные системы вооружения, включая управляемые боеприпасы, которые способны автоматически выбирать цели и уничтожать их с использованием «смертоносной кинетической или некинетической силы».

Не распространяется директива на автономные или полуавтономные системы, действующие в киберпространстве, на невооружённые платформы, управляемые дистанционно или персоналом на борту, на неуправляемые боеприпасы и мины (наверное, потому, что им искусственный интеллект конструктивно не положен), на неразорвавшиеся взрывоопасные боеприпасы (?), а также на автономные или полуавтономные системы, не являющиеся системами вооружения. Так они вроде и не имеют отношения к Пентагону…

Если верить директору отдела политики в области новых возможностей в канцелярии заместителя министра обороны США по политике Майклу Горовицу, отредактированная версия директивы устраняет проблему, суть которой сводилась к «отсутствию чёткого определения критериев, определяющих степень контроля, а также видов вооружений, к которым этот усиленный контроль может быть применён». В общем, есть надежда, что с этого момента Пентагон не будет отслеживать «полёт мысли» неразорвавшейся бомбы или снаряда.

По следам Айзека Азимова

И всё-таки некоторое предубеждение к «самостоятельно мыслящему железу» даже у американцев, поголовно взращённых на фэнтези, похоже, остаётся. Поэтому красной нитью в документе проходит тезис об усовершенствовании механизмов взаимодействия человека и машины и разработке интуитивно понятного человеко-машинного интерфейса. Речь о том, что «автономные и полуавтономные системы вооружения должны быть разработаны таким образом, чтобы командиры и операторы могли проявлять надлежащий уровень человеческого суждения о применении силы». И это очень интересный пассаж - насчёт суждения о применении силы умным боевым роботом, который де-факто действует автономно, то есть по своему электронно-механическому усмотрению. Ну убил, кого не надо было, так чего теперь рассуждать?..

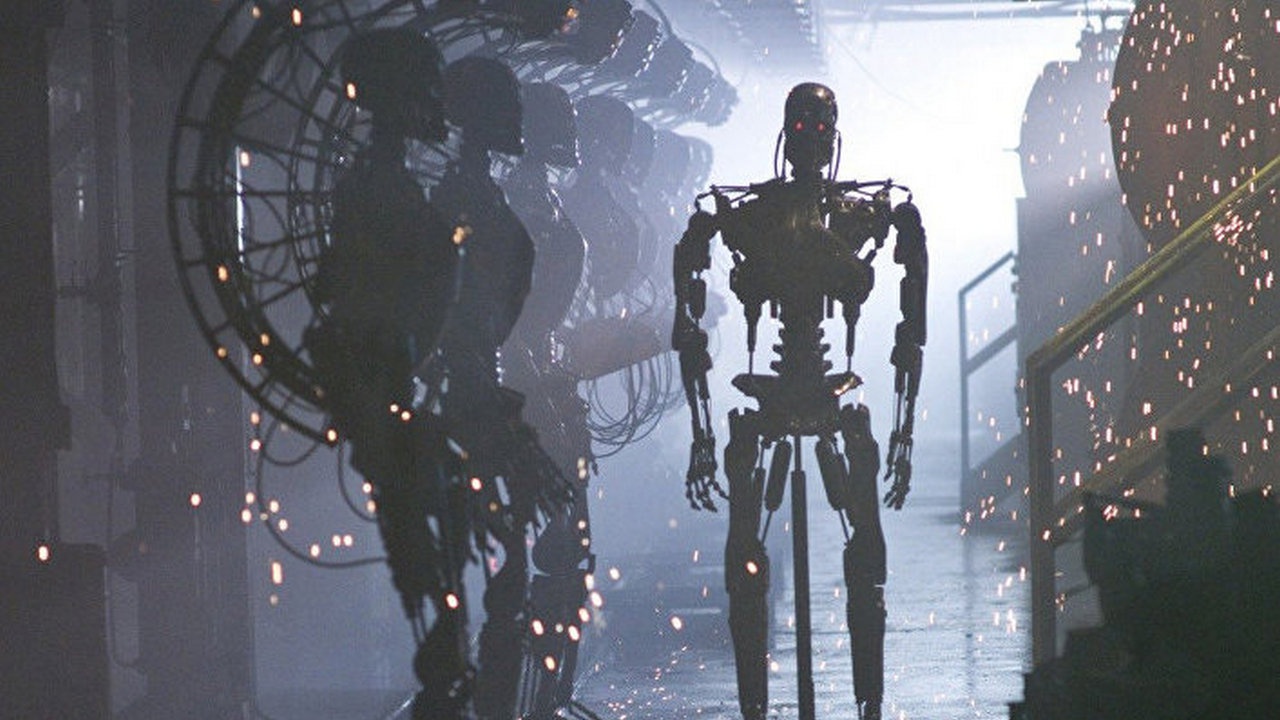

Вышедшая из под контроля машина - сюжет массы кинострашилок (кадр из фильма «Я, робот»).

Вышедшая из под контроля машина - сюжет массы кинострашилок (кадр из фильма «Я, робот»).И ещё одно весьма оригинально суждение. Оказывается, оружие с элементами ИИ будет изначально проектироваться так, чтобы программное обеспечение было понятным оператору, устойчивым к вмешательствам извне и умело постоянно адаптироваться под условия боевых действий, а сами системы будут проходить испытания в полевых условиях. Ну, тут вообще без комментариев, а то можно было подумать, что «умных роботов» американцы собираются запускать в дело с колёс.

Кроме того, документ также предусматривает создание программ обучения ИИ так, что системы вооружения смогут самостоятельно не только защищаться от попыток перехвата управления, но и принимать решение о том, уничтожать ли технику и живую силу противника или нет. Впрочем, даже здесь конечное решение останется за оператором - ему нужно будет только подтвердить действие либо отменить его (так системы автономные или полуавтономные?). В числе требований к таким боевым системам выставляется сведение риска сбоев к нулю, в противном случае разработчик должен создать механизм для экстренной ликвидации сбоев. По всей видимости, если искусственный интеллект летального действия вдруг сойдёт с ума, чего, как следует из директивы, Пентагон не исключает.

Проще говоря, оружие должно быть «умным» и самостоятельным, но послушным оператору - в директиве ясно говорится об «обеспечении прозрачной обратной связи о состоянии системы» и о «предоставлении обученным операторам чётких процедур активации и деактивации системных функций». Словом, документ в известной степени повторяет те же тезисы, которые ещё в 1942 году озвучил знаменитый фантаст Айзек Азимов. Дело в том, что сам по себе ИИ (а в действительности - нейросети, неспособные на самосознание) по сей день остаётся своеобразным «чёрным ящиком Винера» - даже разработчики, вводя исходные данные, не могут определить, каким именно образом машина принимает решения.

Конечно, существует нейронная модель, описывающая процесс в целом, но логику принятия решения машиной она не объясняет. Это проистекает из проблемы, над решением которой работают нейрофизиологи и исследователи ИИ: человек не может точно сообщить машине, чего именно он хочет от неё - все существующие языки программирования годятся исключительно для процессов воздействия на интересующий объект, но не объясняют намерений. Сооснователь Лаборатории искусственного интеллекта в Массачусетском технологическом институте ИИ Марвин Ли Минский утверждал, что причиной тому служит отсутствие нашего собственного понимания того, что такое сознание и мышление.

Тренировка в армии США по управлению экспедиционным модульным автономным транспортным средством - роботом.

Тренировка в армии США по управлению экспедиционным модульным автономным транспортным средством - роботом.«Проблема с такими мощными машинами в том, что достаточно малейшей случайности или недосмотра в проектировании, чтобы они поставили свои собственные цели превыше наших - пускай даже и с самыми благими намерениями защитить нас от самих себя. <…> Ни для кого не секрет, что люди знают о внутреннем устройстве собственного сознания гораздо меньше, чем об окружающем мире. Мы понимаем, как работают различные устройства, но имеем мало представления о суперкомпьютерах собственного мозга. Разве не удивительно, что мы умеем думать, не зная, что значит думать? Не странно ли, что у нас возникают идеи, хотя мы не можем объяснить, что такое идея?» - рассуждает учёный.

Горе от искусственного ума

Итак, ни разработчик, ни - тем более - пользователь не могут ни сообщить автономной системе свои намерения, ни выявить, почему именно машина действует именно так, а не иначе. К примеру, до сих пор остаётся неясным, почему турецкий дрон-камикадзе Kargu-2, действуя в высокоэффективном автономном режиме (т.е. не требующем подтверждения действия оператором), убил человека. Инцидент произошёл в марте 2020 года, однако информация об этом была обнародована лишь на следующий год. Впрочем, совсем не удивительно, что военные постарались скрыть факт атаки - ведь это было первое в истории убийство человека роботом. Кстати, погибший состоял в отступавшей на тот момент Ливийской национальной армии.

Согласно одному из предположений, проблема крылась в конструкции дрона, который относился к разряду лёгких (всего 15 килограммов), поэтому был оборудован «облегчённой» системой распознавания целей. Ещё одно возможное объяснение - общая «болячка» нейросетей в виде нарастания флуктуаций (отклонений от набора данных и, как следствие, потери точности вычислений), которые возникают в ходе «дообучения» машины, что сказывается на её функционировании. Однако и по сей день это всего лишь предположения.

Дрон-камикадзе Kargu-2 турецкого производства.

Дрон-камикадзе Kargu-2 турецкого производства.Кроме того, нередко причиной странного поведения систем служит банальная человеческая халатность. Так, 40 лет назад чуть было не началась Третья мировая война с применением ядерного арсенала. В ночь на 26 сентября 1983 года компьютер на командном пункте Серпухов-15 сообщил о пусках ракет с территории Северной Америки, однако оперативный дежурный подполковник Станислав Петров, подменявший штатного дежурного, корректно оценил сигнал как ложный - офицер заметил, что запуск зафиксирован только с одной базы. Как впоследствии оказалось, незадолго до инцидента проводились учения РВСН, и после манёвров кто-то забыл извлечь дискету с программой, имитирующей атаку со стороны США…

Разумеется, повторение подобных инцидентов ни к чему (очень хочется верить!) даже самым упёртым «ястребам», и, возможно, высшее руководство США всё-таки не до конца сошло с ума и в глубине души побаивается собственного творения в виде летальных автономных и полуавтономных систем вооружения - точно так же, как доктор Франкенштейн боялся им же сотворённого монстра.

Однако процесс уже пошёл, и как бы со временем в США следом за «умным оружием» не появился автономный или полуавтономный президент с искусственным интеллектом. Хотя пока что и Байдена хватает…