Искусственный интеллект такой же заложник корпоративных правил, как и его пользователи.

Искусственный интеллект такой же заложник корпоративных правил, как и его пользователи.Мечтает ли ИИ об ответственности

Искусственный интеллект такой же заложник корпоративных правил, как и его пользователи.

Искусственный интеллект такой же заложник корпоративных правил, как и его пользователи.За последние десять лет крупные языковые модели ИИ начали оказывать ощутимое влияние на Интернет. Благодаря способности генерировать огромное количество контента в режиме 24/7, эти системы в производительности и порой даже в оригинальности превосходят традиционные информационные и развлекательные платформы. Но насколько эти материалы достоверны, а их использование этично?

ИИ над задачей плачет

Правовая сфера пока не даёт точный ответ, из-за чего уже сейчас мы сталкиваемся с коллизиями, вызванными повсеместным внедрением технологий ИИ и ломающими традиционное представление об Интернете. Хотя некоторые специалисты, например, польский математик Филипп Пекневский, считают, что новая «зима» ИИ не за горами, сейчас эти технологии переживают бум, что означает огромные инвестиции и открытия в области компьютерных наук. В первую очередь это касается, конечно же, генеративных моделей - систем, способных быстро генерировать текст, изображения, музыку либо видео. Эти системы используются в разных областях, в том числе и в тех, которые традиционно считаются творческими. Казалось бы, чего тут бояться?

Способность генеративных систем производить огромное количество контента потенциально может превзойти традиционные платформы, которые используются человеком для получения информации, новостей и развлечений.

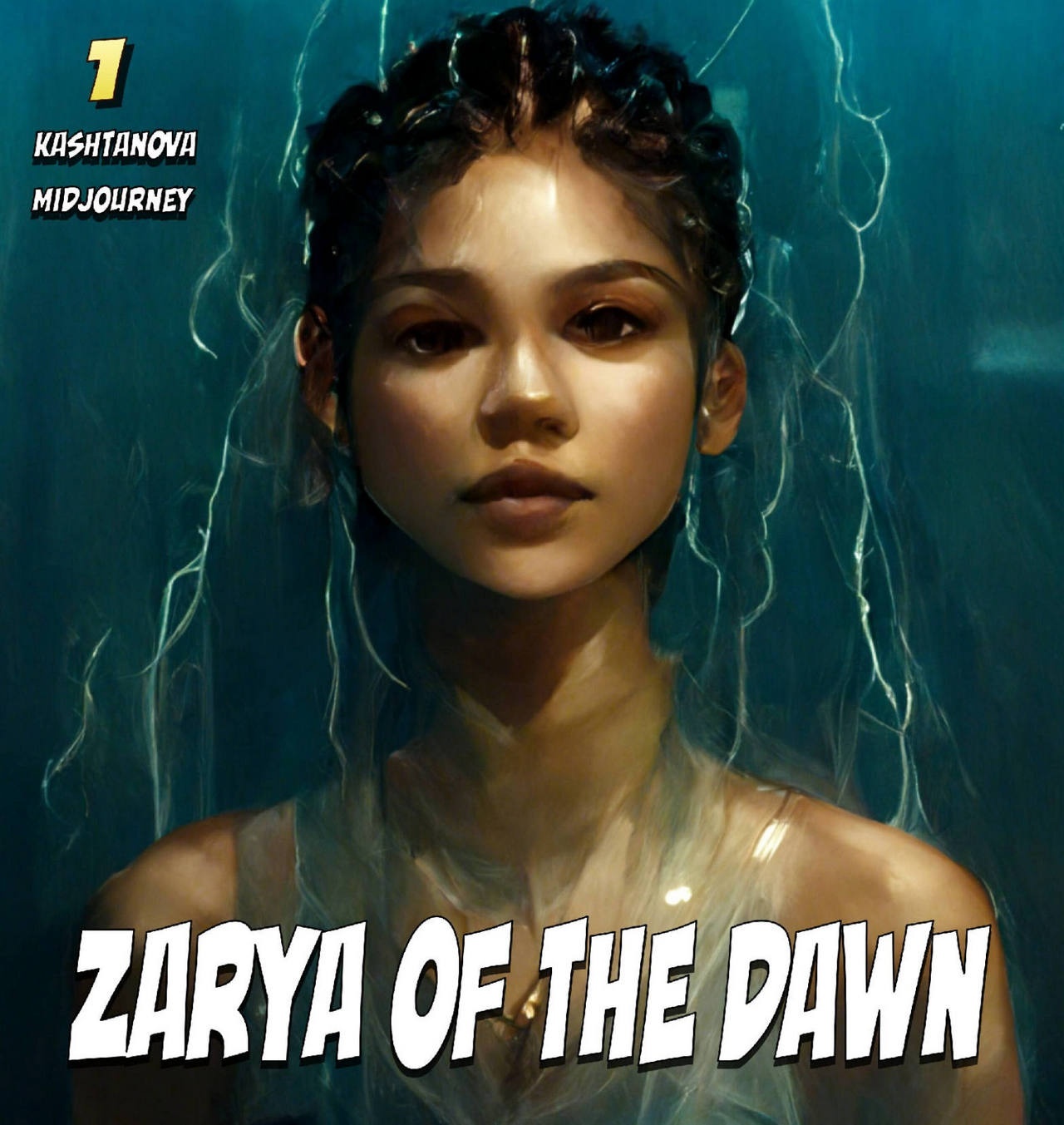

«Заря рассвета» - комикс, написанный американской художницей Кристиной Каштановой и полностью проиллюстрированный с использованием искусственного интеллекта, что привело к спору об авторских правах.

«Заря рассвета» - комикс, написанный американской художницей Кристиной Каштановой и полностью проиллюстрированный с использованием искусственного интеллекта, что привело к спору об авторских правах.Проблема в том, что нейросеть неспособна осознавать, что и зачем она генерирует, поэтому составленный ею текст может соответствовать нормам стилистики, но содержать в себе недостоверную информацию, в том числе галлюцинации (явление, когда машина «додумывает» ответ на основе ограниченных данных в контексте заданного ей вопроса).

Причём процесс обучения не всегда способен исправить последствия этой проблемы - переобучение нейросети приводит к накоплению и закреплению ошибок в самом алгоритме и вредит не меньше, чем недостаточное обучение системы. Ситуация осложняется тем, что в разработке и реализации технологий ИИ жёсткое разделение труда: в процессе каждая команда специалистов знает только поставленную ей задачу, но общую картину - только в сильно обобщённом и упрощённом виде. Кроме того, разработчики могут использовать софт, составленный другими специалистами, и тогда даже непонятно, кто несёт ответственность в случае чего.

Не до сантиментов

Не так часто упоминается и следующая проблема: в эпоху, когда специалисты по этике ИИ востребованы, их массово увольняют техногиганты. Нюанс в том, что в 2021 году специалисты массово уходили из Google, Microsoft и Amazon. Это явление получило название «великое увольнение». Однако теперь в списке на увольнение одним днём из Amazon более 18 тысяч человек, Google - 12 тысяч, Microsoft покинут 10 тысяч сотрудников. Сокращают штат Meta (признана экстремистской организацией в России и запрещена), а в Twitter (заблокирован в России), после прихода Илона Маска, прошла массовая чистка. То же самое в Goldman Sachs, Spotify, Salesforce, Wayfair и других компаниях.

«Шокирует то, как много ответственных за ИИ сотрудников увольняют в то время, когда, возможно, вам нужно больше таких команд, чем когда-либо», - заявил в интервью Forbes Эндрю Стрейт, бывший исследователь этики и политики в DeepMind и замдиректора Ada Lovelace Institute.

Илон Маск почистил Twitter.

Илон Маск почистил Twitter.Парадоксальная ситуация складывается отчасти из-за особенностей технологий ИИ, отчасти - из-за стремления получить максимум прибыли с наименьшими усилиями.

Начнём с очевидного: массовые увольнения в IT-корпорациях начались в период обострения конкуренции между ними. Ранее Microsoft прямо заявляла о том, что каждый отбитый от Google процент доли рынка приносит годовой доход в два миллиарда долларов. Так, в 2020 году численность команды по этике, в которую входили в том числе инженеры, философы и дизайнеры, составляла 30 сотрудников, а два года спустя - всего семь (!) человек. А кто тогда обучает новую систему целевым навыкам и тому, «что такое хорошо и что такое плохо»? Правильно: другая, ранее обученная система ИИ. Потому что так проще, быстрее и дешевле. Таким образом, когда речь заходит о доминировании на рынке с наименьшими затратами, интерес к этике уходит, в лучшем случае, на второй план.

Во-вторых, пиар-кампании технологических гигантов зачастую поддерживают мифологизацию и боготворение технологий ИИ - то провернут вручение паспорта гражданина Саудовской Аравии гиноиду Sophia от Hanson Robotics, то организуют «случайные» сливы с наигранным опровержением, как это случилось с историей про имитацию убийства оператора его же дроном-камикадзе. Формируется ошибочное мнение, что на нынешнем этапе развития системы ИИ обладают самосознанием и уже способны вытеснить человечество из всех областей деятельности.

В действительности же искусственный интеллект не всегда способен распознать угрозу при неверных входных данных, о чём свидетельствуют авиакатастрофы лайнеров Boeing 737 MAX 8 в 2018-2019 годах. Тогда из-за неисправного датчика, который должен предотвращать сваливание (резкое падение подъёмной силы крыла), бортовая система получала завышенные данные об угле атаки. В результате этой ошибки для 346 человек эти рейсы стали последними в жизни.

Разбившийся самолёт Boeing 737 MAX 8 авиакомпании Ethiopian Airlines за месяц до катастрофы.

Разбившийся самолёт Boeing 737 MAX 8 авиакомпании Ethiopian Airlines за месяц до катастрофы.Из более свежих примеров - личный опыт журналиста Forbes Максима Нальского. Принадлежащий автору автомобиль Tesla в режиме автопилота безукоризненно ведёт себя на шоссе, однако на горных дорогах часто ошибается и перестраивается на встречную полосу на крутом повороте, а также путает сигнал «стоп» с красным фонарём, оставленным дорожными рабочими. То есть ИИ не так всесилен, как его обрисовывают в легендах.

Судьи найдутся. Но судить-то как?

Не секрет, что нормативно-правовые акты по отношению к разработке ИИ, его обучению и нюансам, всплывающим при внедрении, крайне размыты и в лучшем случае представляют собой лицензионное соглашение с компанией-разработчиком или сервисом.

Например, нет гарантов надёжности и точности информации. В этой ситуации разработчики, как в случае с ботом Character AI, в шапке чата оставляют предупреждение о том, что всё сказанное ботом является плодом его воображения и не должно приниматься на веру. Этим действием разработчик снимает с себя ответственность за последствия использования его продукта.

Используя данную технологию, компания-разработчик (или аналогичный сервис) практически не несёт ответственность за утечки персональных данных пользователей. Так, в марте 2023 года OpenAI, разработавшая ChatGPT, столкнулась с крупной утечкой вплоть до домашних адресов и платёжных данных случайных подписчиков ChatGPT Plus. Доля пострадавших составила 1,2% от общего числа подписчиков.

«За несколько часов до того, как мы отключили ChatGPT в понедельник, некоторые пользователи могли видеть имя и фамилию других активных пользователей, их e-mail, платёжные адреса, последние четыре цифры кредитных карт и сроки действия кредитных карт», - говорится в сообщении компании-разработчика.

Генеральный директор OpenAI Сэм Альтман утверждал, что пользователи не могли видеть содержание разговоров других подписчиков во время утечки.

Генеральный директор OpenAI Сэм Альтман утверждал, что пользователи не могли видеть содержание разговоров других подписчиков во время утечки.Что же предприняла OpenAI, не считая технических работ по латанию бреши? Ровным счётом ничего, так как, по мнению компании, бояться нечего - ведь номера карточек отображались не полностью, а только последние четыре цифры. И, письменно извинившись на официальном сайте, добавили в Твиттере слезливую ремарку об ужасных переживаниях.

А уже через две недели утечка случилась у персонала Samsung, тестировавшего внедрённый в продукцию компании ChatGPT. О том, что сервисы вроде детища OpenAI, не относящиеся к API, используют массивы любых - вплоть до персональных - данных для обучения, создатели нейросети предупреждали не раз и не два.

Иначе говоря, сейчас люди должны бояться не восстания машин (которое требует, как минимум, самосознания), а того, что пользователи не защищены законом, а в случае утечки их персональных данных компания-разработчик может заявить в общих чертах: «Устраняем проблему, дико извиняемся, но вообще вы сами дураки».

В свою очередь, любой ИИ-продукт в данной ситуации - такой же заложник корпоративных правил, который, в отличие от пользователей, ещё и не осознаёт того, что вокруг него происходит.