Президент Трамп стал звездой Deepfake.

Президент Трамп стал звездой Deepfake.Deepfake - ключевая особенность любых выборов в любой стране

Президент Трамп стал звездой Deepfake.

Президент Трамп стал звездой Deepfake.В ходе встречи Владимира Путина и Дональда Трампа на саммите G20 в Осаке американский лидер в шутку попросил русских не вмешиваться в предстоящие выборы. Тема вмешательства «русских хакеров» в выборы долгое время была ключевой при обсуждении отношений России и США. Однако после расследования спецпрокурора Роберта Мюллера, в котором опровергаются любые попытки российского вмешательства, у американского правительства не осталось способов оправдаться. Поэтому они решили обратить эти обвинения в шутку.

Американский лидер попросил русских не вмешиваться в предстоящие выборы.

Американский лидер попросил русских не вмешиваться в предстоящие выборы.Следующие выборы состоятся в 2020 году. И теперь, когда «русские хакеры сложили свои полномочия», американцы начали искать новые пути вмешательства в свои в выборы. И ими стали нейросети.

Справка

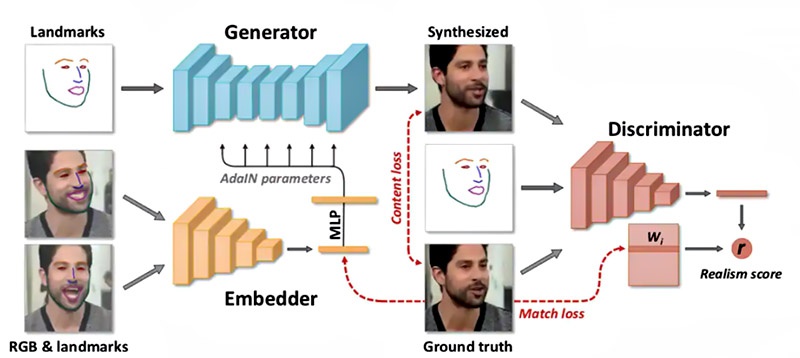

Нейросеть, или искусственная нейронная сеть, - программное обеспечение, созданное из совокупности взаимосвязанных простых программ и процессов, сопряжённых по принципу сетей нервных клеток живого организма. Задача нейросети - распознать и обработать входные данные и использовать их для решения поставленной задачи. Ключевая особенность такой системы - способность к самообучению.

На данный момент большинство известных нейросетей используются для научных исследований или развлечения. Существуют программы, которые могут сами написать музыку различных жанров, нарисовать картину или написать текст. Правительства государств пока только присматриваются к нейросетям, предлагая использовать их для математических расчётов или управления беспилотными аппаратами. Очевидно, что все развитые страны занимаются разработками в этой области, но ожидать их появления в краткосрочной перспективе не стоит.

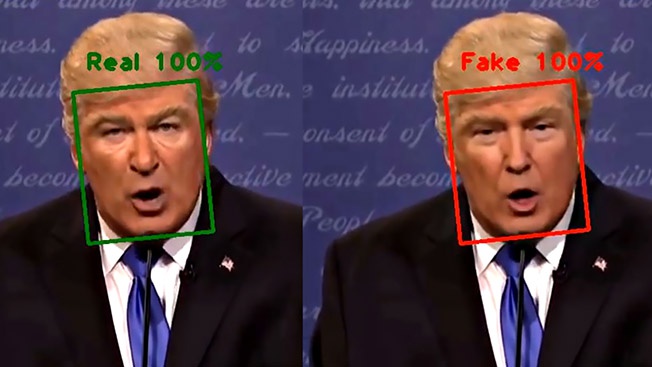

Большой резонанс вызвало появление нейросети Deepfake. Её задача - «заменить лицо» на видео. Программа может проанализировать лицо человека на фотографии и на его основе создать цифровую маску, которую можно установить на любое видео. Звучит пугающе. Особенно для американцев перед выборами. Представьте: можно создать провокационное видео, в котором кандидат на должность президента США может сказать и сделать что угодно, тем самым вызвав международный скандал.

Задача Deepfake - «заменить лицо» на видео.

Задача Deepfake - «заменить лицо» на видео.«Мы живём во время, когда стоит относиться скептически ко всему, что мы видим на видео. Я считаю, что "дипфейки" станут ключевой особенностью предстоящих выборов. И мы будем ещё долго наблюдать за последствиями», - сообщил старший научный сотрудник Института Брукингса Джон Вилласенор во время выступления в Сенате США.

Стоит ли серьёзно воспринимать слова американского учёного? И да и нет. «Дипфейки» действительно вызвали беспокойство у мировой общественности. Администрация социальной сети Facebook даже предупредила пользователей, что не допустит появления провокационных «дипфейков» на страницах своего сайта. Тем не менее, количество видео, созданных с помощью нейросети, неуклонно растёт. Однако до сих пор никому не удалось вызвать международный скандал и «подставить» какого-либо политика. Почему?

Дело в том, что технологии нейросетей несовершенны. Вышеупомянутые музыкальные нейросети хоть и могут написать музыкальное произведение, такие композиции вряд ли могут создать у кого-либо впечатление, что их сочинил талантливый музыкант. То же самое можно сказать и о Deepfake. Если посмотреть видео, созданное этой нейросетью, то сразу становится заметно, что лицо человека искажается, как будто находится не на своём месте.

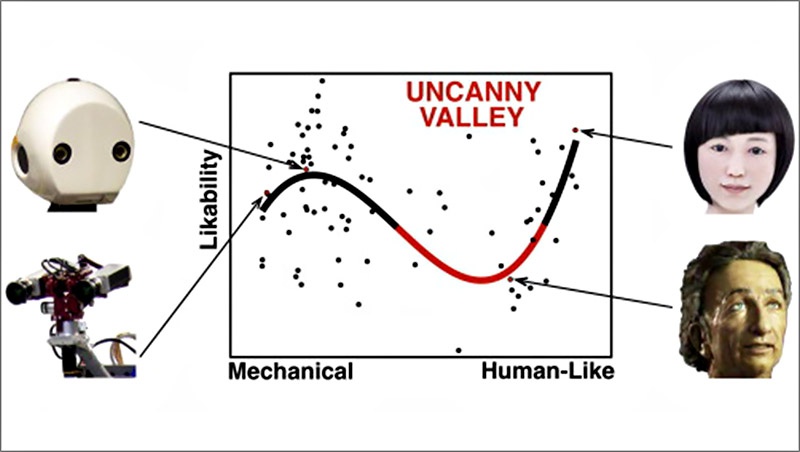

Человеческий мозг очень трудно обмануть. Ещё в 1978 году японский учёный Масахиро Мори, в ходе исследования эмоциональной реакции человека на внешний вид роботов, обнаружил удивительный факт. Чем больше робот похож на человека, тем симпатичнее для человека он кажется. Но только до определённого момента.

Как только робот становится максимально похож на человека, в глаза бросаются любые недостатки. Малейший недочёт, любое неестественное движение или внешний недостаток человеческий мозг воспринимает как угрозу. Таким образом, любое отличие от настоящего человеческого лица может вызвать у наблюдателя дискомфорт или даже страх. Этот феномен был назвал «эффектом зловещей долины».

«Эффект зловещей долины» - любое отличие от настоящего человеческого лица может вызвать у наблюдателя дискомфорт или даже страх.

«Эффект зловещей долины» - любое отличие от настоящего человеческого лица может вызвать у наблюдателя дискомфорт или даже страх.Об этом эффекте не понаслышке знают кинематографисты. В то время как современные мультипликаторы старательно избегают возникновения этого эффекта, не желая пугать юных зрителей, авторы фильмов ужасов часто используют «эффект зловещей долины» для создания чудовищ, которые могут одним своим видом заставить смотрящего дрожать от страха.

То же самое чувство возникает и при просмотре «дипфейков». Даже если человек не заметит подмену, его подсознание всё равно забьёт тревогу. Результаты работы нейросети не способны превзойти навыки голливудских аниматоров, а даже они не могут воплотить на экране естественную замену лица. Например, после просмотра очередной серии фильма «Звёздные войны» многие зрители жаловались, что лицо актрисы Кэрри Фишер, которое попытались «омолодить» с помощью компьютерной графики, вызывает у них чувство тревоги и страха.

Исследованиями реалистичности «дипфейков» занимались и американские учёные. Каталин Григорас, директор национального центра судебно-медицинской экспертизы США, провёл исследование и доказал, что эксперты-криминалисты с лёгкостью распознают подделку, обращая внимание на недостатки работы нейросети и несоответствие качества лица и оригинального видео.

Из этого следует вывод, что серьёзно повлиять на выборы американского президента «дипфейки» не смогут. Да, будут появляться поддельные видео, так как доступ к этой программе может получить каждый. Но и воспринимать провокационные видео всерьёз сможет разве что человек, который ничего не понимает в современных технологиях. К тому же в США явно дали понять, что будут отслеживать любые подделки и создавать опровержение в случае необходимости.

Искусственные нейронные сети созданы по принципу сетей нервных клеток живого организма.

Искусственные нейронные сети созданы по принципу сетей нервных клеток живого организма.Современные технологии ещё не достигли того уровня, на котором возможно обмануть человеческий разум. Американские политики обозначили факт существования подобных нейросетей, но одновременно преувеличили серьёзность ситуации. «Deepfake представляет угрозу для нашей национальной безопасности и честности наших выборов», - заявил член палаты представителей США Дерек Килмер.

Да, подобные нейросети действительно могут нести угрозу для национальной безопасности. Но только в далёком будущем, когда программисты создадут более реалистичные способы подделывать видео и смогут обучить этому нейросети. В конгрессе США уже разрабатываются законы о контроле программного обеспечения на основе нейросетей. И они могут пригодиться. Но не сейчас. На выборы в 2020 году Deepfake повлиять не может. Это факт.